La OTAN descubre el negocio de las operaciones en redes

Introducción

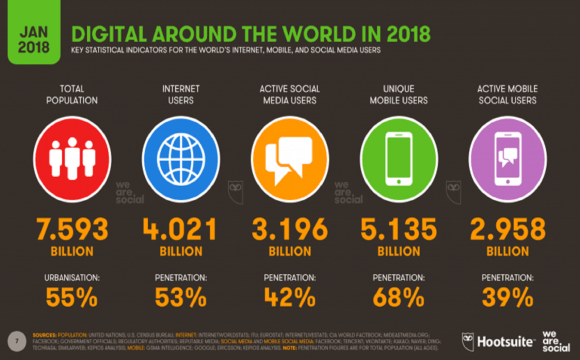

El Centro de Excelencia de Comunicaciones Estratégicas de la OTAN (StratCom, por sus siglas en inglés), ubicado en Riga, difundió el 6 de diciembre de 2019 el informe titulado “Falling Behind: How Social Media Companies Are Failing to Combat Inauthentic Behaviour Online”, en el que asegura que entre un 20% y un 30% del tráfico de internet es puro ruido generado por bots (sistemas automatizados) dañinos y está creado para confundir a las plataformas y a los usuarios.

El principal objetivo de este informe es levantar el dedo acusador contra Rusia, país al que acusa de “dominar el mercado de manipulación de redes sociales… Los principales proveedores de software e infraestructura de manipulación identificados por nosotros son de origen ruso.”

Si embargo, las conclusiones del informe admiten que el fraude en las redes sociales tiene enormes proporciones, no se circunscribe solo a Rusia y se manipula tanto el discurso político como las operaciones comerciales. Según el Stratcom, las empresas que se dedican a estas operaciones blanquean su actividad con anuncios en las mismas plataformas a las que timan, y compiten entre ellas a precio muchas veces para utilizar los mismos recursos y convergir en las mismas webs.

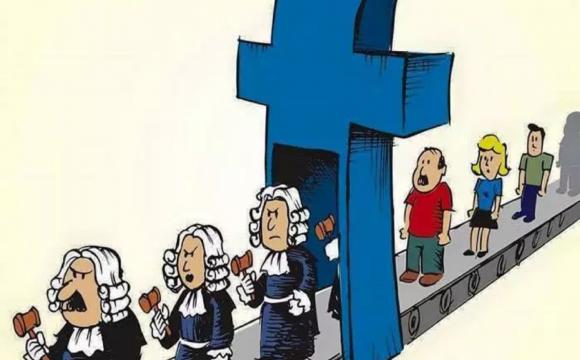

Aunque Facebook, Twitter, Youtube e Instagram (propiedad de Facebook) han asegurado que refinan sus algoritmos para identificar los fraudes, según la OTAN, estos actúan más para penalizar a particulares que intentan crear cuentas falsas, que para castigar a los grandes cárteles del mercado negro de la manipulación, capaces de crear hasta niveles de sofisticación en el fraude, con distinto rango de ofertas.

Experimento de la OTAN

Para probarlo, el StratCom de la OTAN contrató a la consultora ucraniana Singularex, que hizo un experimento en el que con solo 300 euros compró 105 publicaciones (páginas) diferentes en Facebook, Instagram, Twitter y YouTube a través de 11 proveedores de servicios de manipulación que se ofrecen en línea: 6 rusos y 5 europeos (1 polaco, 2 alemanes, 1 francés, 1 italiano).

Por 300 euros, obtuvieron las siguientes interacciones para sus cuentas:

- 3 520 comentarios.

- 25 750 “Me gusta” o “likes”.

- 20 000 visitas.

- 5 100 seguidores nuevos.

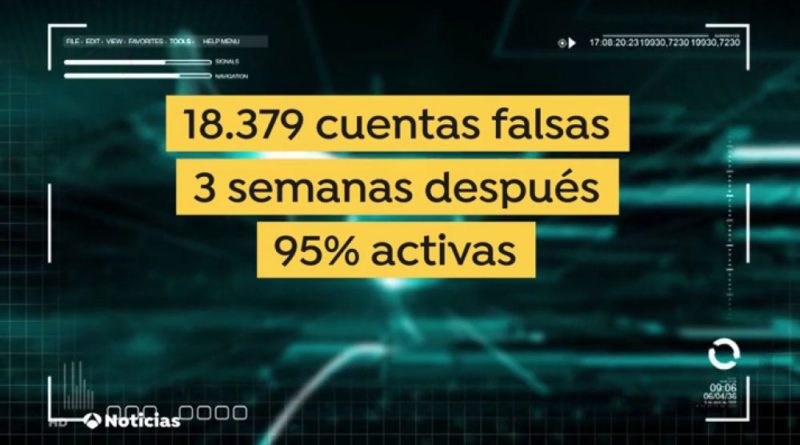

El estudio de las interacciones lo que les permitió localizar otras 18 739 cuentas falsas en esas plataformas.

El experimento pidió a las empresas contratadas que pusieran sus comentarios en páginas de las OTAN y de la Comisión Europea en Facebook, Twitter, Instagram y Youtube. Pidió que estos comentarios no fueran demasiado relevantes (apolíticos), y esperaron a que las propias plataformas las detectaran.

Dos meses después, denunciaron las cuentas falsas y esperaron a ver cuánto tardaban las plataformas en borrarlas. Entre cinco y seis días en el mejor de los casos. Tres semanas después de reportar las cuentas falsas, más del 95% de estos perfiles todavía estaban activos en línea.

Al estudiar las cuentas falsas detectadas en las páginas compradas, identificaron que intervenían en la conversación social de otras 721 páginas de contenido político y 52 páginas pertenecientes a gobiernos, entre las que se encuentran las cuentas oficiales de dos presidentes e incluso la página de un grupo político europeo.

El estudio reveló que Facebook suspende el 80% de las cuentas falsas denunciadas; Twitter el 66%; Instagram (propiedad de Facebook), el 50%; y Youtube ninguna. Instagram no logra detectar los seguidores falsos y apenas elimina el 5% de sus comentarios. En cambio, Youtube tiene éxito en reducir el número de visionados falsos (aquellos que realiza una máquina y no un humano). Y no hay diferencia entre cuentas verificadas y sin verificar, por lo que reclaman más transparencia en los criterios de las compañías.

Metodología utilizada en el experimento

El experimento financiado por la OTAN evaluó la capacidad de las plataformas para eliminar las interacciones falsas, a través de 5 pasos:

- Comprar “me gusta”, comentarios, opiniones y seguidores para post neutrales en las cuentas no auténticas que había comprado.

- Comprar “me gusta”, comentarios, opiniones y seguidores para publicaciones apolíticas neutrales.

- Seguir paso a paso, el rendimiento y tiempo de respuesta de las plataformas en la eliminación de las actividades no auténticas.

- Seguir el tiempo que las cuentas no auténticas permanecen en las plataformas de los medios sociales y la manera en la que se relacionan.

- Seguir en tiempo real, lo que tardan las cuentas en ser eliminadas.

Resultados de la investigación

La manipulación de las redes sociales es la nueva frontera para los antagonistas que buscan influir en las elecciones, polarizar la opinión pública y desviar las discusiones de las políticas legítimas.

Los compradores van desde individuos que buscan aumentar su popularidad, personas influyentes que utilizan el sistema de publicidad en línea y actores estatales con motivaciones políticas.

La manipulación de medios sociales se basa en cuentas no auténticas que se relacionan con otras cuentas en línea para influir en la percepción pública de las tendencias y la popularidad.

Algunas cuentas no auténticas son cuentas simples, controladas por bots (abreviatura de robot) que replican imágenes, videos o retuitean contenido a partir de un programa de computadora. Otros son cuentas elaboradas o “envejecidas” con largas historias destinadas a ser indistinguibles de los usuarios genuinos.

Los bots son una forma muy rentable de generar alcance artificial y crear una ola de “aprobación social”, ya que los usuarios típicos tienen más probabilidades de confiar y compartir contenido que ha sido del agrado de muchos otros.

Las cuentas controladas por bots cuestan solo unos pocos centavos cada una y se espera que se bloqueen rápidamente, aunque -como demuestra esta investigación- suelen tener larga vida cuando hay detrás empresas especializadas en operaciones de manipulación. Las cuentas inauténticas más elaboradas requieren un control humano directo. Pueden costar hasta varios cientos de euros y a menudo permanecen en línea durante años.

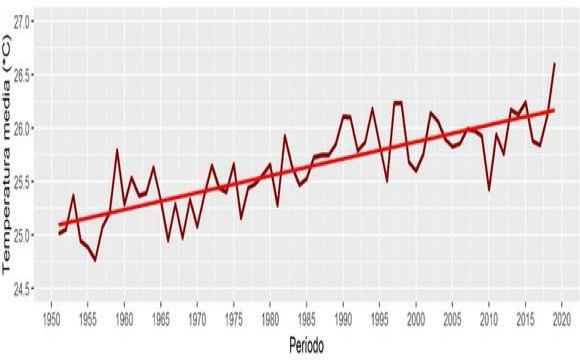

El informe de la OTAN también asegura que “la industria de la manipulación está creciendo año tras año y no hay señal de que se esté volviendo sustancialmente más costoso o más difícil de realizar una manipulación generalizada de las redes sociales”.

En contraste con los informes presentados por las propias plataformas transnacionales ante la Unión Europea (Twitter, Facebook, Google), el informe de la OTAN “presenta una perspectiva diferente: estábamos en capacidad fácilmente de comprar más de 54 000 interacciones auténticas de redes sociales con poco o nada resistencia”.

Basado en este experimento y varios otros estudios que la OTAN ha realizado en los últimos dos años, “Facebook, Instagram, Twitter y YouTube siguen sin poder contrarrestar adecuadamente el comportamiento no auténtico en sus plataformas la autorregulación no funciona”.

Aunque la lucha contra la desinformación en línea y el comportamiento inauténtico coordinado está lejos de terminar, “un hallazgo importante de nuestro experimento es que las diferentes plataformas no son igualmente malas, de hecho, algunas son significativamente mejores que otras a la hora de identificar y eliminar cuentas y actividades manipuladoras. La inversión, los recursos y la determinación hacen una diferencia”.

Facebook, Instagram, Twitter y YouTube siguen sin poder contrarrestar adecuadamente el comportamiento no auténtico en sus plataformas, asegura el informe.

Las medidas implementadas por Twitter para evitar la creación de cuentas no auténticas fueron especialmente difíciles de eludir, dice el informe. “Twitter debe ser elogiado por hacer todo lo posible para combatir el uso malicioso de su plataforma. Actualmente están por delante de las otras plataformas que probamos. Aun así, todavía es muy posible manipular contenido y conversaciones en Twitter, solo requiere un poco más de esfuerzo que en otras plataformas.”

Por tanto, esto refuerza la idea compartida por los expertos de Mueve América Latina que elaboraron el informe sobre la operación de cuentas falsas para apoyar el golpe de Estado en Bolivia -se lograron documentar cerca de 100 000 perfiles falsos creados en muy corto tiempo, la mayoría en la primera semana de noviembre -, que esto no pudo hacerse sin la colaboración de la plataforma con los operadores políticos interesados en contaminar el diálogo social contra el Presidente Evo Morales.

Resumen de las principales conclusiones

- El “mercado negro” para la manipulación de las redes sociales es mayor de lo que se puede documentar.

- La infraestructura para desarrollar y mantener softwares de manipulación de redes sociales, generar cuentas ficticias y proporcionar proxies móviles es enorme. El desarrollo de esta industria es sorprendente.

- En lugar de producirse un inframundo sombrío, es un mercado de fácil acceso al que la mayoría de los usuarios de la web pueden llegar con poco esfuerzo a través de cualquier motor de búsqueda. De hecho, los proveedores de servicios de manipulación se anuncian abiertamente en las principales plataformas.

- El tamaño de la industria de manipulación de redes sociales es preocupante. Hemos identificado cientos de proveedores. Varios tienen muchos empleados e ingresos significativos. Está claro que el problema de la actividad no auténtica es extenso.

Recomendación de la OTAN

- Establecer normas y exigir que la presentación de informes se base en criterios más significativos.

- Aumentar la transparencia.

- Establecer una supervisión independiente y bien dotada de recursos.

- Regular el mercado de la manipulación de los medios sociales.

- Las plataformas de medios sociales necesitan hacer más por contrarrestar el abuso de sus servicios.

- Búsqueda de una solución para toda la industria

“La autorregulación no funciona. La industria de la manipulación crece año tras año. No vemos ninguna señal de que se esté volviendo sustancialmente más caro o más difícil llevar a cabo una manipulación generalizada de los medios de comunicación”, aclaran desde el StratCom de la OTAN.

Herramientas de la UE para prevenir el abuso de las plataformas

Las compañías de redes sociales han hecho varias declaraciones formales expresando su intención de abordar el abuso de sus plataformas. El compromiso formal más claro se produjo en septiembre de 2018, cuando representantes de las principales plataformas en línea acordaron un Código de prácticas autorregulatorio para abordar la propagación de desinformación de línea.

Una parte importante del Code of Practice (Código de Conducta) fue el compromiso de establecer políticas claras para identificar y manejar el mal uso de bots automatizados, y hacer cumplir estas políticas dentro de la Unión Europea. (Ver European Commission. “Code of Practice on Disinformation” September 26, 2018.)

En víspera de las elecciones europeas de 2019, la Comisión y el Grupo de Reguladores Europeos para los Servicios de Medios Audiovisuales (ERGA) evaluaron las acciones tomadas por Facebook, Google y Twitter con base en informes presentados.

Al abordar “La desinformación en línea: un enfoque europeo”, la Comisión Europea señaló que:

La exposición de los ciudadanos a la desinformación a gran escala, incluida información falsa o totalmente falsa, es s un gran desafío para Europa. […]

Las nuevas tecnologías se pueden utilizar, especialmente a través de las redes sociales, para difundir la desinformación a gran escala, con velocidad y precisión de focalización sin precedentes, creando esferas de información personalizadas y convirtiéndose en potentes cámaras de eco para campañas de desinformación. […]

Las campañas masivas de desinformación en línea están siendo ampliamente utilizadas por una variedad de actores nacionales y extranjeros para sembrar la desconfianza y crear tensiones sociales, con graves consecuencias potenciales para nuestra seguridad. (Ver European Commission. “Annual Self-Assessment Reports of Signatories to the Code of Practice on Disinformation 2019”.)

Dispositivo de OTAN para la guerra híbrida

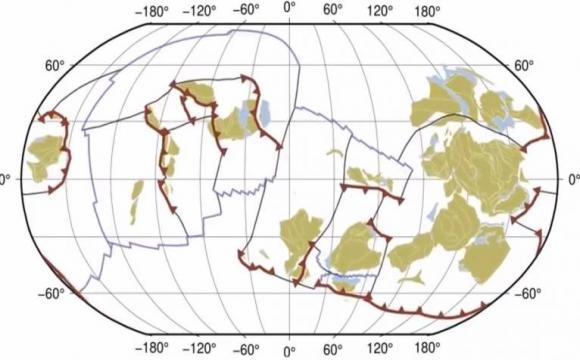

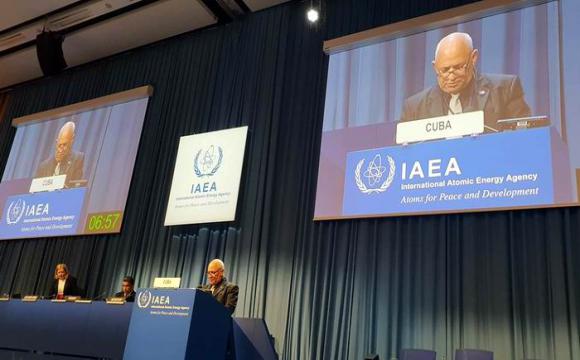

La OTAN posee tres Centros de Excelencia (CoEs) — el de Lituania que emite este informe (creado en el 2012), Letonia (2014) y Estonia (2008)-, que trabajan coordinados con la División de Desafíos Emergentes (ESCD) y el Programa Ciencia para la Paz y Seguridad (SPS), para acciones de guerra híbrida.

La División de Desafíos Emergentes (ESCD — Emerging Security Challenges Division) establecida en 2010 se ocupa de riesgos y amenazas no convencionales, con secciones especificas relativas a Antiterrorismo, Ciberdefensa, Seguridad Energética, No-proliferación, Análisis Estratégico, Seguridad Económica y Política Nuclear.

Por su parte, el Programa Ciencia para la Paz y Seguridad (SPS — Science for Peace and Security) promueve la investigación e innovación científica y el intercambio de conocimiento relacionados con actividades relevantes para la seguridad, de acuerdo con los objetivos de la Alianza. Tiene un enfoque práctico y de aplicación operativa, englobando a científicos, expertos y funcionarios de países aliados y asociados. (Ver: Guerra híbrida y capacidades estratégicas de la OTAN: Aportaciones de Lituania, Letonia y Estonia”, del Instituto de Estudios Estratégicos de España)

Añadir nuevo comentario